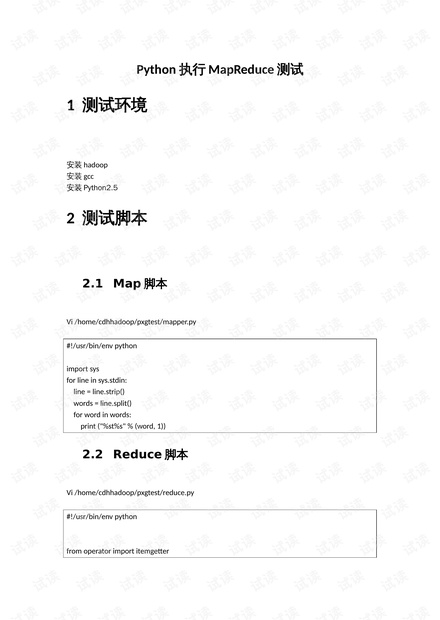

### Python执行MapReduce测试知识点详解 #### 一、测试环境搭建 在进行Python MapReduce测试之前,需要确保以下环境配置已经完成: 1. **安装Hadoop**:Hadoop是实现MapReduce模型的基础软件,用于分布式处理大数据集。 2. **安装GCC**(GNU Compiler Collection):虽然对于本测试而言并非必需,但在某些情况下可能需要编译一些本地代码或库,因此建议安装。 3. **安装Python 2.5**:尽管Python 2.5已经过时,但在这个特定的测试案例中使用了该版本。需要注意的是,现代系统中更推荐使用Python 3.x版本。 #### 二、MapReduce概念理解 **MapReduce**是一种编程模型,用于大规模数据集(通常大于1TB)的并行运算。它包括两个主要阶段:Map阶段和Reduce阶段。 - **Map阶段**:将输入数据分割成多份,每一份数据由一个Map任务处理。Map函数对每一份数据执行相同的操作,并将处理结果输出为键值对的形式。 - **Reduce阶段**:将Map阶段产生的中间结果按照键分组,并分配给Reduce任务处理。Reduce函数对每个键的多个值进行聚合操作,最终输出结果。 #### 三、测试脚本编写 ##### Map脚本 ```python #!/usr/bin/env python import sys for line in sys.stdin: line = line.strip() words = line.split() for word in words: print("%s\t%s" % (word, 1)) ``` **解析**: - 脚本读取标准输入流中的每一行数据。 - 将每行数据分割成单词。 - 对于每个单词,输出其与计数值1的键值对。 ##### Reduce脚本 ```python #!/usr/bin/env python from operator import itemgetter import sys word2count = {} for line in sys.stdin: line = line.strip() word, count = line.split('\t', 1) try: count = int(count) word2count[word] = word2count.get(word, 0) + count except ValueError: pass sorted_word2count = sorted(word2count.items(), key=itemgetter(0)) for word, count in sorted_word2count: print("%s\t%s" % (word, count)) ``` **解析**: - 读取标准输入流中的每一行数据。 - 按照`\t`分隔符分割每行数据,获取单词及其对应的计数值。 - 使用`word2count`字典存储每个单词的累计计数值。 - 按照单词排序后输出每个单词的总计数值。 #### 四、测试文本准备 创建一个简单的测试文本文件`test.txt`,内容为: ``` aab c d e f b c ``` #### 五、Hadoop HDFS目录配置 - 创建Hadoop HDFS目录`/user/pythontest`: ```bash hadoop fs -mkdir /user/pythontest ``` - 上传测试数据到HDFS目录: ```bash hadoop fs -put /home/cdhhadoop/pxgtest/test.txt /user/pythontest/ ``` #### 六、测试结果分析 - **执行测试脚本命令**: ```bash hadoop jar /home/cdhhadoop/hadoop/share/hadoop/tools/lib/hadoop-streaming-2.5.0-cdh5.2.0.jar \ -file /home/cdhhadoop/pxgtest/mapper.py \ -mapper /home/cdhhadoop/pxgtest/mapper.py \ -file /home/cdhhadoop/pxgtest/reduce.py \ -reducer /home/cdhhadoop/pxgtest/reduce.py \ -input /user/pythontest/* \ -output /user/pythontest/output ``` - **日志解析**: - 日志显示了Hadoop Streaming的一些警告信息,提示`-file`选项已弃用,建议使用`-files`选项。 - 显示了任务提交过程的信息,如任务的路径、输入文件的数量等。 - 提供了跟踪作业的URL,方便监控作业执行状态。 #### 七、总结 通过上述步骤,我们成功地使用Python实现了MapReduce的基本功能,并在Hadoop平台上进行了测试。这种测试不仅验证了MapReduce程序的正确性,也为实际应用中处理大规模数据提供了基础。需要注意的是,在实际生产环境中,还需要考虑更多的优化措施以及异常处理策略,以确保系统的稳定性和高效性。

- 粉丝: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 多媒体计算机问答题.doc

- 人工智能背景下的就业新态势及其职业教育应对策略.docx

- 论网络知识产权保护.docx

- 网络教学平台建设(终稿).doc

- 第6章程序设计基础.ppt

- 嵌入式系统与接口技术实验项目卡.doc

- 软件品质管理流程.doc

- 电子CAD教学设计.doc

- 有关施工项目管理与成本控制的问题分析.docx

- 七可编程序控制器程序设计方法.ppt

- 《计算机组装与维护》课程体系改革探究.docx

- 单片机与DSB数字温度计设计.doc

- 课程思政视域下网络流行语在高校现代汉语课程中的融合分析.docx

- 企业财务管理信息化存在的问题及其对策.docx

- 图书馆电子阅览室网络安全及其防范技术.docx

- 数字图像处理实验研究报告doc.doc

信息提交成功

信息提交成功