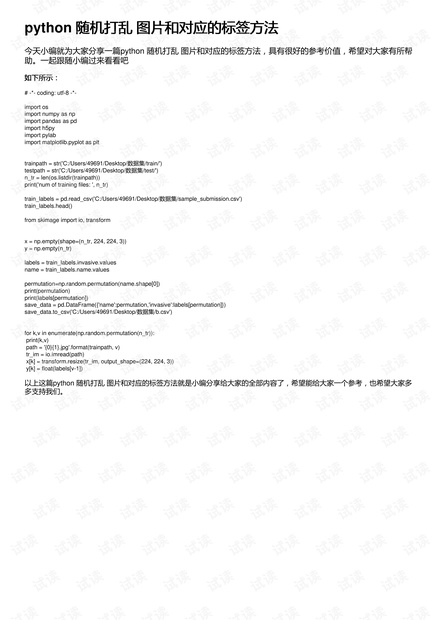

### Python随机打乱图片及其对应标签的方法 在深度学习与机器学习项目中,尤其是在处理图像数据时,数据预处理是一个非常关键的步骤。本文将详细介绍如何使用Python来随机打乱图像数据及其对应的标签,这对于训练模型来说至关重要,因为它能够帮助模型更好地泛化。 #### 知识点概览 1. **导入所需库** 2. **加载图片和标签** 3. **使用NumPy进行随机打乱** 4. **保存打乱后的数据** ### 导入所需库 我们需要导入一系列用于处理图像数据的Python库: ```python # -*-coding:utf-8-*- import os import numpy as np import pandas as pd import h5py import pylab import matplotlib.pyplot as plt ``` - **os**:用于操作系统相关的功能,如读取文件路径。 - **numpy (np)**:用于数值计算和数组操作。 - **pandas (pd)**:用于数据处理和分析。 - **h5py**:用于读写HDF5文件格式,但在这个示例中未使用。 - **pylab**:matplotlib的一个子模块,提供了MATLAB风格的绘图功能。 - **matplotlib.pyplot (plt)**:用于绘制图形。 ### 加载图片和标签 接下来,我们需要定义训练数据和测试数据的路径,并统计训练文件的数量: ```python train_path = str('C:/Users/49691/Desktop/数据集/train/') test_path = str('C:/Users/49691/Desktop/数据集/test/') n_tr = len(os.listdir(train_path)) print('数量 of 训练文件:', n_tr) train_labels = pd.read_csv('C:/Users/49691/Desktop/数据集/sample_submission.csv') ``` 这里假设`sample_submission.csv`文件包含了每个图片的名称(`name`)和其对应的标签(`invasive`)。 ### 使用NumPy进行随机打乱 为了随机打乱图片及其对应的标签,我们可以使用NumPy中的`np.random.permutation()`函数。该函数可以返回一个指定长度的随机排列数组: ```python labels = train_labels['invasive'].values names = train_labels['name'].values permutation = np.random.permutation(names.shape[0]) print(permutation) print(labels[permutation]) ``` 这里,`permutation`是一个随机排列的索引数组,可以根据它来重新排序原始的数据。 为了验证随机打乱的效果,我们可以将打乱后的标签存储到一个新的DataFrame中,并保存为CSV文件: ```python save_data = pd.DataFrame({'name': names[permutation], 'invasive': labels[permutation]}) save_data.to_csv('C:/Users/49691/Desktop/数据集/b.csv') ``` ### 加载并处理图像 最后一步是根据新的顺序加载图片,并将其转换为适当大小的数组: ```python x = np.empty(shape=(n_tr, 224, 224, 3)) # 存储图像数据 y = np.empty(n_tr) # 存储标签 for k, v in enumerate(np.random.permutation(n_tr)): print(k, v) path = '{0}{1}.jpg'.format(train_path, v) tr_im = io.imread(path) x[k] = transform.resize(tr_im, output_shape=(224, 224, 3)) y[k] = float(labels[v - 1]) ``` 这里,`x`数组用于存储图像数据,而`y`数组则存储对应的标签。每张图片被读取后会使用`skimage.transform.resize()`函数调整为统一的大小。 ### 总结 通过上述步骤,我们可以有效地对图像数据及其对应的标签进行随机打乱,这有助于提高模型训练的效果。值得注意的是,在实际应用中,还需要根据具体需求对代码进行适当的调整和完善,比如增加异常处理、优化性能等方面。此外,还可以考虑使用更高级的数据加载工具,如TensorFlow或PyTorch中的数据加载器,这些工具提供了更强大的功能和支持,可以帮助开发者更加高效地处理大规模数据集。

- 粉丝: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 小型超市管理系统数据库课程设计.doc

- 系统集成过程中的物料管理探究.docx

- 基于北斗定位技术的智慧交通信息共享系统研究.docx

- plc控制电梯大学设计.doc

- 互联网+背景下小学双线英语绘本教学探究.docx

- 大数据时代经管类高端应用型人才培养模式探讨.docx

- 软件测试于质量保证题库.doc

- MDword-PHP资源

- 软件需求分析的研究现状.doc

- Profibus在网络化测控系统中技术原理附其应用.docx

- 【精品ppt】互联网医疗科技风演示.pptx

- 《JAVA语言程序设计》期末考试试题及答案1应考必备题库.doc

- PLC控制电镀生产线课程设计.doc

- 自动售货机单片机程序PROTUES仿真.doc

- 医院信息化建设汇报.doc

- layui-JavaScript资源

信息提交成功

信息提交成功