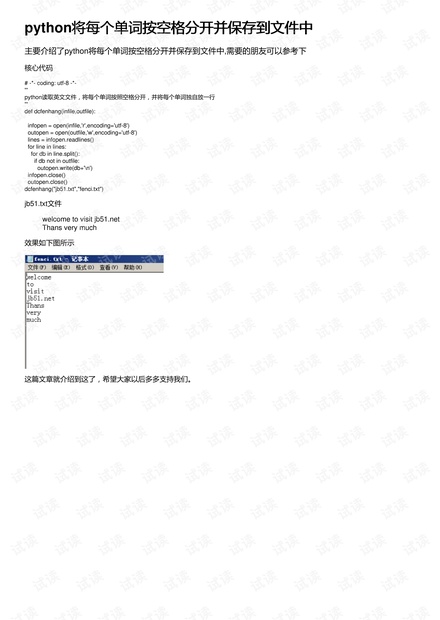

在Python编程语言中,处理文本数据是常见的任务之一。标题提到的"python将每个单词按空格分开并保存到文件中",这是一个基础但实用的操作,尤其在文本处理、数据分析或者自然语言处理(NLP)等领域。下面我们将详细讨论如何实现这个功能。 我们需要导入必要的库。在这个例子中,因为没有涉及到其他库,所以我们不需要导入任何额外的库。Python的标准库已经提供了足够的功能来完成这个任务。 核心代码中的`dcfenhang`函数是实现目标的关键。它接受两个参数:`infile`代表要读取的源文件名,`outfile`则是处理后结果的保存文件名。这个函数的目的是将`infile`中的每个单词独立出来,每行写入一个单词到`outfile`。 函数内部,首先使用`open()`函数以读模式('r')打开源文件,并指定编码为'utf-8',确保能正确处理中文字符。同样,也以写模式('w')打开目标文件,同样设定编码为'utf-8'。`readlines()`方法用于读取源文件的所有行,并存储为一个列表。 接下来,对每一行进行遍历。`line.split()`函数会根据空格将当前行分割成单词列表。这里默认空格是分隔符,也可以通过传递参数自定义分隔符。然后,对于列表中的每一个单词(`db`),如果它不在目标文件(`outfile`)中,就将其写入目标文件,每行一个单词。这里通过`not in`操作符判断单词是否已存在于目标文件,注意这个判断在实际应用中可能不够准确,因为它是基于整个文件内容的字符串比较,而不是基于已写入的单词集合。在大规模文本处理时,更推荐使用集合(set)来跟踪已写入的单词,以提高效率。 关闭两个文件流以释放系统资源,这是良好的编程习惯。 在示例中,源文件`jb51.txt`包含两句话:"welcome to visit jb51.net" 和 "Thans very much"。运行代码后,目标文件`fenci.txt`会将这些单词分别写入,每个单词占一行。 这个简单的操作在文本处理中有着广泛的应用,例如统计文本中的词汇频率、去除停用词、构建词汇表等。通过理解这个基本过程,你可以进一步扩展到更复杂的文本处理任务,如词性标注、句法分析、情感分析等。希望这个解释有助于你理解和运用Python处理文本数据。

- 粉丝: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 广州市区道路网络深化规划研究.docx

- 学校网站方案设计书大学本科方案设计书方案设计书.doc

- 制造及自动化—榨汁机内支架塑料模具设计.doc

- 数据库技术在Web中的应用论文.doc

- 大数据时代对中国失业现状的研究分析.docx

- 基于单片机的数字时钟方案设计书08758.doc

- 谈机械自动化技术发展趋势和要点分析.docx

- 单片机万年历方案设计书.doc

- 27-基于MC51单片机的简易计算器方案设计书.doc

- 实验Oracle基本用户安全管理实验.doc

- 单片机原理及接口技术课程设计(CO气体浓监测仪设计).doc

- 《单片机原理与应用》021.ppt

- NOSQL-DB:Hbase-列式数据库七问.doc

- 童发发的大模型学习之旅

- 信息化时代下高校会计教育中存在的问题及对策.docx

- 浅析计算机网络工程全面信息化管理探讨.docx

信息提交成功

信息提交成功